Wie Facebook unsere Gedanken lesen will

Die Meldung sorgte für Verunsicherung und Späße gleichermaßen. Auf seiner Entwicklerkonferenz F8 hat Facebook angekündigt, Gedanken in Schrift auf dem Computer verwandeln zu wollen. Facebook will also unsere Gedanken lesen. “Solche Technologie existiert heute nicht. Wir werden sie erfinden müssen”, sagte Regina Dugan, Chefin von Building 8, Facebooks Erfinderschmiede. Wie realistisch ist dieses Ziel? Kann Facebook bald unsere Gedanken lesen? Ein Gastbeitrag von Robert von Cube

Brain-to-Computer-Interfaces

Gehirn-zu-Computer-Schnittstellen (BCIs), gibt es bereits. Theoretisch ist auch die Tastatur, die ich gerade bediene, eine solche Schnittstelle, bei der aber der recht banale Umweg über meine Finger gegangen wird. Aber ist es auch möglich, einen Computer zu bedienen, ohne irgendeine Bewegung auszuführen? Cathy Hutchinson ist vollständig gelähmt. Dennoch kann sie aus einer Tasse Kaffee trinken. Sie tut es, indem sie einen Roboter-Arm mit ihren Gedanken steuert. Necomimi sind, bitte festhalten!, bunte Katzenohren, die man sich auf den Kopf setzt und die mittels EEG-Elektroden messen, ob man konzentriert oder entspannt sind. Sie bewegen sich, um den Zustand des Trägers anzuzeigen. Und die Forscher Christian Herff und Tanja Schultz entwickeln ein BCI, mit dem sie aus Gedanken Text auslesen können.

Wie geht denn Denken?

Der Reihe nach. Wie funktionieren diese Techniken, die wahlweise nach Science Fiction oder Zauberei klingen? Grundlage ist immer, dass die Hirnaktivität gemessen wird und das Ergebnis von einem Computer ausgewertet und weiterverarbeitet wird. Die modernen bildgebenden Verfahren haben die Kentnisse darüber, wo im Gehirn etwas passiert, wenn wir denken, wahrnehmen oder tun, erheblich vertieft. Unser Gehirn besteht aus einer gewaltigen Zahl von Nervenzellen, die über eine noch viel gewaltigere Zahl von Synapsen miteinander verbunden sind. Jede dieser Zellen hat eine spezielle Funktion, repräsentiert gewissermaßen irgendeinen Reiz. So gibt es Zellen, die immer dann aktiviert werden, wenn meine Augen etwas Blattförmiges sehen. Andere springen an, wenn ich Grün sehe. Wieder andere springen an, wenn meine Ohren einen bestimmten Laut hören, z.B. das Wort “Blatt”.

Jedesmal, wenn ich als Baby etwas grünes, blattförmiges gesehen habe und gleichzeitig meine Mutter das Wort “Blatt” sagen hörte, haben sich die Verbindungen zwischen diesen Zellen verstärkt. Und wenn ich heute ein Blatt sehe, springen die Zellen, die für das Wort “Blatt” zuständig sind, gleichermaßen an, obwohl ich das Wort nicht wirklich höre. Ich denke es. Und umgekehrt, wenn ich “Blatt” denke, springen auch die Zellen an, die für “Grün” verantwortlich sind und ich sehe das Grün vor meinem geistigen Auge.

Das Gehirn gliedert sich in eine Vielzahl von Arealen, in denen zusammengehörige Nervenzellen (Neuronen) gruppiert sind. So gibt es z.B. ein Gebiet, das für meinen rechten Arm zuständig ist (bestehend aus all den vielen Zellen, die den Ellenbogen, die Hand, die Finger, die Fingerkuppen, etc. repräsentieren). Wenn ein Schlaganfall dieses Areal zerstört, ist mein Arm gelähmt. Wenn der Infarkt groß ist und auch die angrenzenden Gebiete erwischt, trifft es vielleicht die ganze Körperhälfte. Diese Gebiete sind natürlich auch aktiv, wenn ich meinen Arm bewege, sie steuern ihn ja. Sie sind sogar aktiv, wenn ich nur daran denke meinen Arm zu bewegen. Und diese Aktivität kann man messen.

innerlich und äußerlich, Durchblutung und Strom

Es gibt verschiedene Methoden, so eine Aktivität zu messen, und sie unterscheiden sich insbesondere darin, ob sie invasiv (also in den Körper eingreifend) oder oberflächlich sind. Sie Unterscheiden sich auch darin, was sie messen.

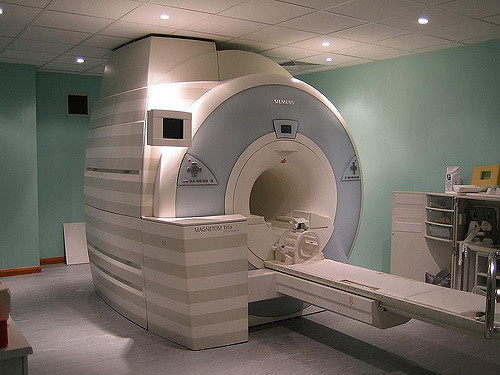

Es gibt insbesondere zwei Dinge, die man ableitet, um die Aktivität eines Gehirnareals zu ermitteln. Nämlich die elektrische Aktivität (in den Nervenzellen fließt ja ein Strom) und die Durchblutung. Diejenigen Hirnareale, die gerade arbeiten, sind stärker durchblutet, was man erfassen kann. Hierfür eignet sich ein funktionales MRT, also eine Methode, die auf starken Magnetfeldern beruht. Eine andere Variante ist die Nahinfrarotspektroskopie, bei der die Absorption von Licht über der Schädeldecke gemessen wird. Tatsächlich dringt nämlich etwas Licht einer bestimmten Wellenlänge durch unsere Kopfhaut und den Knochen bis ins Gehirn. Da, wo das Licht dann auf Hämoglobin (den roten Blutfarbstoff) trifft, wird es anders absorbiert und das kann man messen. Stark durchblutete Areale lassen sich so identifizieren.

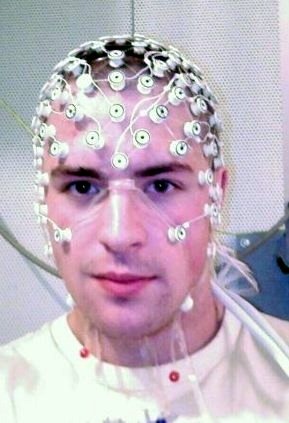

Die andere Variante ist die Messung der elektrischen Aktivität. Die klassische Methode hierfür ist ein EEG (Elektroenzephalogramm). Hierbei wird dem Probanden ein Netz mit Elektroden auf den Kopf gesetzt, ein wenig wie eine Badekappe mit Kabeln daran. Diese Elektroden messen den schwachen elektrischen Strom an der Kopfhaut, der aus der Aktivität des Gehirns stammt. Dadurch, dass man eine Vielzahl von Sensoren über die Oberfläche des Kopfes verteilt, kann man nicht nur messen, dass Strom fließt, sondern auch wo. Diese Methode ist schon sehr alt und vielfach erprobt. Ein einfaches EEG kann zumindest recht deutlich zeigen, ob die linke oder rechte Gehirnhälfte aktiv ist, der vordere oder hintere Abschnitt und auch in welchem Stadium (entspannt, schlafend, konzentriert) es sich befindet. Damit arbeiten die Katzenohren. Der Nachteil ist, dass die Ströme verhältnismäßig schwach und “verwaschen” sind, zumal die Elektroden auch auf Muskelaktivität reagieren. Jedes Zwinkern, Zucken, Kopfschütteln stört das Ergebnis.

Viel genauer sind daher Messungen, die direkt am Gehirn abgeleitet werden. Was nach einem Horror-Film klingen mag, ist wissenschaftliche Realität und hilft tagtäglich vielen kranken Menschen. Denn längst werden Elektroden direkt in oder auf das Gehirn implantiert. Ähnlich wie ein Herzschrittmacher im Herzen sitzt und elektrische Impulse abgibt, um die Erregung des Herzens sicherzustellen, gibt es Schrittmacher im Gehirn bei Parkinson-Patienten. Bei dieser Erkrankung sterben Nervenzellen ab, die für die Bewegung zuständig sind. Mittels “tiefer Hirnstimulation” können diese Zellen künstlich angeregt werden und die Symptome werden gelindert. Auch bei Epilepsien werden solche Elektroden implantiert und im Versuchsstadium werden auch psychische Erkrankungen auf diese Weise angegangen. Die Ableitung des EEGs direkt auf der Hirnrinde, dem Cortex, nennt man Elektrokortikogramm (ECoG)

Der Forscher Phil Kennedy hat sich im Selbstexperiment eine Elektrode implantieren lassen, um seine BCI-Forschung voranzutreiben, aber üblicherweise werden solche Studien mit Menschen durchgeführt, die aus medizinischen Gründen eine solches Implantat sowieso benötigen. Schließlich handelt es sich um einen schwerwiegenden Eingriff am offenen Gehirn. Dafür sind die Signale, die man empfängt, um ein Vielfaches stärker und präziser als bei einem normalen EEG.

Vom Kopf zum Bildschirm

Wie geht es nun weiter? Nur weil ich messen kann, dass irgendwo eine Aktivität geschieht, steuere ich ja noch keinen Computer.

Die einfachsten Schnittstellen funktionieren so, dass der Proband ein EEG abgeleitet bekommt und sich dann vorstellt, z.B. die rechte oder die linke Hand zu bewegen. Dann wird im EEG eine erhöhte Aktivität in der linken oder rechten Hirnhälfte gemessen (umgekehrt zur vorgestellten Hand, aus anatomischen Gründen) und die kann im Computer als Eingangs-Signal verwendet werden. So kann man z.B. in einem Spiel festlegen, dass die Figur nach links geht, wenn man “links” denkt und umgekehrt. Fügt man noch eine Achse für oben und unten hinzu (indem man z. B. an Füße oder Zähne denkt), hat man ein Koordinatensystem, auf dem man sogar einen Cursor bewegen kann.

Es gibt Patienten mit dem sogenannten “locked-in”-Syndrom, also Menschen, die bei klarem Bewusstsein vollständig gelähmt sind, die auf diese Weise kommunizieren können. Sie bewegen einen Cursor auf einem Bildschirm von Buchstabe zu Buchstabe. Und das ist schon unser erstes, real bestehendes Brain-to-Text-Interface. Frau Dugan von Facebook bezieht sich auf Studien dieser Art, die in Stanford gemacht werden. Hier wird mit einem Implantat gearbeitet.

Für diese Menschen, die bislang wegen ihrer schweren Lähmungen kommunikationsunfähig waren, ist das ein unglaublicher Gewinn. Aber als Alternative zur Texteingabe für Gesunde ergibt diese Methode meines Erachtens wenig Sinn. Man stelle sich vor, man müsste mit der Maus jeden Buchstaben nacheinander auf dem Bildschirm auswählen – nur in Gedanken. Selbst wenn das Inferface schnell und zuverlässig funktionieren würde, wäre das mühsam. Die Patienten in Stanford schaffen bis zu 39 Buchstaben in einer Minute. Ich tippe dies hier im Zehnfingersystem mit 200–300 Anschlägen in der Minute.

Brain-to-text

Aber es gibt auch schon Experimente für eine Schnittstelle, um Gedanken direkt in Text umzuwandeln. Die oben erwähnten Forscher Christian Herff und Tanja Schultz von der Universität Bremen haben sie durchgeführt. Wie funktioniert das?

Sie haben Menschen, die wegen einer Epilepsie eine Elektrode auf die Oberfläche ihres Gehirns implantiert bekommen haben, gebeten, Texte vorzulesen. Während des Lesens haben sie ihr ECoG (also das EEG direkt auf der Hirnrinde) gemessen. Man hat die Texte in einelne Phone (kleinste Lauteinheiten, vereinfacht gesagt so etwas wie Buchstaben) unterteilt und den Computer analysieren lassen, welche spezifische Hirnaktivität mit welchem Phon verbunden ist. Der Computer hat also gewissermaßen trainiert und an verschiedenen Textbeispielen eine Vielzahl von Lauten und deren Pendant im ECoG miteinander verglichen. Er hat somit eine Wahrscheinlichkeit errechnet, dass eine bestimmte Konstellation im ECoG mit einem bestimmten Phon zusammengehörig ist.

Von den zehn gelesenen Texten hat man dem Computer jeweils einen vorenthalten. Und dann sollte der Computer anhand seiner Rechnungen aus dieser “Aufnahme” (es war eine Aufnahme von Hirnaktivitäten, nicht von Sprache!) einen Text generieren. Der Computer hat sich also die Hirnsignale “angeschaut” und gesagt: “Dies ist höchstwahrscheinlich ein a, dies ein p” etc. Daraus hat er dann den Text zusammengesetzt, den der Proband seiner Meinung nach “gedacht” hat (der Proband hat den Text auch gesprochen, dazu komme ich gleich noch mal, aber wie gesagt, der Computer hat nur die Messung seiner Hirnaktivität zu Gesicht bekommen).

Und, Fazit: Das hat ganz gut funktioniert. Im Experiment hat man sich allerdings darauf beschränkt, dem Computer zwischen 10 und 100 Wörtern anzubieten, die er erkennen sollte. Bei 10 Wörtern hat er auf diese Weise aber immerhin 75% der “gedachten” Wörter richtig erkannt. Das ist auch nicht so viel schlechter, als Siri auf meinem iPhone schafft. Bei 100 Wörtern waren es nur noch 40%, die korrekt erkannt wurden. Aber es geht ums Prinzip und das Prinzip lautet: Ein Computer kann Wörter erkennen, die man denkt.

Denken oder Sprechen?

Eine wichtige Einschränkung ist aber zu machen: Die Probanden haben die Texte vorgelesen, dass heißt, sie haben die Wörter beim Lesen zwar natürlich auch gedacht, aber sie haben sie auch gehört, weil sie ihre eigene Stimme vernommen haben. Es ist unklar, wieviel der gemessenen Werte auch über die Wahrnemung der eigenen Stimme mit den Ohren und die dadurch verursachte Aktivität in den akustischen Bahnen des Gehirns bedingt ist. Es könnte sein, dass lautlos gedachte Sprache weniger oder andere Messwerte verursacht und die Ergebnisse vielleicht schlechter gewesen wären, hätten die Probanden die Texte im Stillen gelesen (Die Abgleichung mit dem Text wäre dann übrigens auch nicht möglich gewesen, weil man ja nicht hätte wissen können, an welcher Stelle sie gerade sind. Das Problem ist somit grundsätzlicher Natur, weil man die Experimente nicht einfach mit stummem Text wiederholen kann).

Ein MRT im Rucksack?

Jetzt haben wir also gesehen, dass es grundsätzlich möglich ist, einem Computer in Gedanken einen Text zu diktieren. Es führt bislang nur zu 10–100 Wörtern, aber das ist das kleinste Problem. Das größere Problem ist die Messung. Denn bislang ist ein sehr riskanter Eingriff am offenen Gehirn erforderlich. Ein Hosentaschen-MRT ist nicht in Aussicht, da würde schon eher die optische Messung per Nahinfrarotspektroskopie in Frage kommen. Allerdings sind diese Methoden, die den Blutfluss messen, für Textlösungen ungeeignet, weil sie zu langsam sind. Die Veränderung der Durchblutung, selbst wenn sie sehr genau aufgelöst würde, spielt sich im Bereich von Sekunden ab.

Um einzelne Phone eines flüssig diktierten Textes zu unterscheiden, ist eine viel schnellere Methode erforderlich. Ein Brain-to-Text-Interface der Zukunft müsste daher auf der elektrischen Ableitung beruhen. Unlängst wurde das klassische EEG durch Kombination mit bildgebenden Verfahren deutlich verbessert. Tatsächlich lässt sich, wie im verlinkten Video gezeigt, eine Drohne zuverlässig alleine mit den Gedanken steuern, ganz ohne Implantat.

Aber diese Methode beruht weiterhin auf dem recht simplen Koordinatensystem das ich oben beschrieben habe. Ich kann mir nicht vorstellen, dass sie hochauflösend genug ist, um die präzisen Veränderungen im Hirnstrom zu messen, die Herff und Schultz in ihren Experimenten benötigt haben, um gedachte Laute zu identifizeren. Eine greifbare Lösung würde also nach bisherigem Stand mindestens erfordern, dass man still sitzt und nicht blinzelt und sich eine Art Badekappe aufsetzt und dann mühsam mit einem Cursor Buchstabe für Buchstabe auswählt. Klingt nicht gerade alltagstauglich.

Aber wer weiß, vielleicht setzt sich in 30 Jahren durch, dass man tatsächlich Elektroden ohne dringende medizinische Erforderlichkeit implantiert, wie Dr. Kennedy.

Gedankenlesen?

Kann Facebook also bald unsere Gedanken lesen? Bislang sprechen wir nur davon, dass ein Computer einen Text ausliest, der gewissermaßen “laut gedacht” wird oder eben, noch einfacher, ein Cursor gesteuert wird, der auf die Buchstaben zeigt. Der Computer muss vorher angelernt werden. Das heißt, dass ein BCI nur bei demjenigen funktioniert, mit dem es vorher “trainiert” hat. Theoretisch wäre denkbar – wenn man eine Vielzahl von Probanden auf diese Weise trainieren lässt – ein statistisches Mittel zu finden, das ganz Allgemein zutrifft. Sofern denn die Verarbeitung dieser Signale bei verschiedenen Individuen ähnlich genug ist, um überhaupt solche Gemeinsamkeiten zu finden. Das ist Zukunftsmusik.

Dann jedenfalls könnte es, rein theoretisch, denkbar sein, auch das Aktivitätsmuster eines Unbekannten mit dem statistischen Mittel zu vergleichen und dessen Gedanken auszulesen. Auch gegen seinen Willen. Allerdings würde man lediglich das erfahren, was er in Gedanken “laut aufsagt”. Echtes Gedankenlesen ist noch viel weiter weg. Denn das wirkliche Denken ist viel komplexer. Da schwingen innere Bilder mit, implizites Wissen, halb gedachte Assoziationen, Erinnerungen, Unbewusstes, Gefühle. Rein theoretisch könnten auch die gelesen werden, vermute ich.

Doch ein Computer, der das vermöchte, ist meiner Überzeugung nach nicht in Sicht.

"Doch ein Computer, der das vermöchte, ist meiner Überzeugung nach nicht in Sicht."

Es wird Zuckerzwerg auch nicht um *einen* Computer gehen, sondern um Big Data, Brute Force Datamining, Cluster, Netze etc., also um alles, was die Müllsammelmaschine Facebook heute schon hergibt. Fragt sich nur, wieviele Millionen FB-Gehilfen es dann braucht, um falsch interpretierte Gedanken zu "korrigieren".

Ein interessanter Artikel.

Ich hatte mir den Vortrag von Frau Dugan angeschaut.

Ist das revolutionär? Was will man damit?

Final geht es doch darum, dass man mithilfe optischer Methoden gedachte, aber bewusste Informationen als Input aus dem Gehirn erfassen will und dass man mithilfe von Sensoren auf der Haut Informationen übertragen will.

Was bringt das? Für Menschen mit Einschränkungen ist das sehr hilfreich. Sie entwickeln mit ihren Gehirnen erstaunliche Fähigkeiten wie bspw. die Orientierung mit Klicklauten wie bei Fledermäusen.

Wenn ich daran denke, dass ich deutlich schneller schreiben als denken kann und der Autor des Texts sogar bis zu 300 Anschläge angibt, ist es fraglich, worin der allgemeine Mehrwert liegen soll.

Geht darum versch. Sprachen zu überwinden bzw. Übersetzungen zu vermeiden? Ich glaub nicht, denn versch. Kulturen denken anders.

Insgesamt geht Facebook wohl davon aus, dass die Zeiten der Events, Hochglanzfotos etc. ausgereizt sind. Es wird der Alltag in den Mittelpunkt gestellt. Da liegt auch der Wert für weitere relevante Daten, die dann analysiert werden können.

Interessant waren in ihrem Vortrag einige Einstellungen:

"The risk of failure is the price we pay for the privilege of making something great"

"Commit to being a little bit terrified each day"

Die meisten Leute beherrschen ja kein Zehnfinger-System und die Eingabe von Text auf dem Smartphone ist finde ich immer noch einer der größten Schwachpunkte. Es wäre also durchaus eine Erleichterung, wenn man den Text einfach "denken" könnte. Vielleicht reicht es für Facebook schon, die Hemmschwelle für die Benutzung zu senken. Aber vermutlich würden sie noch mehr Innovationen herausholen wollen, wenn sie irgendwann wirklich soweit wären. Aber wie gesagt: die Richtung, die sie einschlagen, die sich auf die Auswahl von Buchstaben per Cursor bezieht, hat m.E. keine Perspektive, diese Erleichterung zu schaffen.

Danke für den Hinweis mit dem Vortrag: Ich wusste nicht, dass man ihn ansehen kann, hatte nur die Artikel dazu gelesen. Schaue ich mir gleich mal an!

Ja, aber ob ein Computer oder eine Big-Data-Netzwerk – die Informationsdichte, die man ableiten würde, wenn man "die Gedanken" lesen wollte, ist so hoch und bezieht sich auf so viele individuelle "Systemeinstellungen", dass deren brauchbare Interpretation m.E. nicht in Sicht ist.

@#4: Stimmt schon, aber Zuckerzwerg reicht vermutlich schon eine starke Abstraktion dieser Informationen, ähnlich der kindlich-naiven Emojis, die ja überall im Digitalen Einzug genommen haben und schon eigene Schriftarten bilden.

Es gibt eine Fragestellung, folglich wird daran geforscht. Das zeichnet uns Menschen aus. Aber wird man weit kommen? Ich zweifle daran, wenn ich an Übersetzungsprogramme denke. Was da manchmal an Unsinn herauskommt, ist noch nicht ausgereift. Und weil viele Menschen bevorzugt in Bildern denken, deren Aufbau und Entstehung unbekannt ist, werden erst einmal Forschungen notwendig sein, wie Bilder im Gehirn entstehen. So wie der derzeitige Stand ist, muß ich "Kuh" sagen, oder denken, damit die Maschine auch "Kuh" versteht. Wenn ich aber ein Bild von einer Kuh vor meinem inneren Auge sehe, aber nicht das Wort "Kuh" denke, versteht die Maschine nichts. Insofern ist sie eine Hilfe für Menschen, die weder sprechen noch schreiben können, aber von einer möglichen Anwendung im praktischen Alltagsleben, kann noch keine Rede sein. Das wird vielleicht noch ein-zwei Generationen beschäftigen. Da Kühe selber nicht "Kuh" sagen können, sondern vermutlich in Bildern denken, werden wir noch lange warten müssen, bis wir wissen, was Kühe denken.

Erst wenn das gelingt, mache ich mir Sorgen, daß Menschen mit solchen Methoden verhört werden könnten. Werbung übertragen geht vermutlich schon lange vorher. Das ist sicher. Ob allerdings ein solcher manipulativer Eingriff ins Gehirn bei der Werbung wirkungsvoller ist, als die verführerische Suggestion unserer Tage, wage ich zu bezweifeln.

Etwas (z.B. Werbung) ins Gehirn hineinzubekommen, halte ich für noch unrealistischer, als etwas herauszulesen. Aber ich stimme zu (und schrieb das ja auch), dass der Schritt vom "Diktieren" zum "Gedankenlesen" noch sehr groß ist.

Hat man denn schon versucht, die gemessenen Impulse, einer anderen Testperson, natürlich elektronisch verstärkt, "zuzuspielen"?

Es könnte ja sein, daß das Hirn durchaus die Signale eines anderen Hirns ohne zwischengeschalteten Computer versteht. Dann könnten sich zwei oder mehrere Personen, die unter einer gekoppelten Haube stecken, gedanklich unterhalten.

Bitte bei einer Patentierung daran denken, daß ich diese Frage gestellt habe.

Dann wäre es auch mit dieser Methode endlich möglich "Etwas (z.B. Werbung) ins Gehirn hineinzubekommen,"

Was geht: mittels Elektroden eine bestimmte Stelle im Gehirn reizen (zB während einer OP) und dann die Reaktion auslösen, die eben an dieser spezifischen Stelle im Gehirn verarbeitet wird. ZB ein Zucken des Armes, wenn man das Areal für Armbewegungen reizt oder eine einfache optische Halluzination, wenn man die Sehrinde reizt.

Aber um komplexe Wahrnehmungen oder fremde Gedanken zu "überspielen" müsste man Elektroden an jeder einzelnen Nervenzelle haben und jede einzeln ansteuern können.

Ich kenne das mit Elektroden im Hirn seit den Sechzigern, vielleicht auch seit den Siebzigern. Ist halt lange her. Damals hat man einem Stier eine Elektrode ins Glückszentrum des Hirns eingepflanzt, die über Funk aktivierbar war. Der Stier wurde gereizt, rannte wütend auf den Radiotorero los, und als der die glückszentrumselektrode aktivierte, stoppte der Stier seinen Lauf und war friedlich. Damals war ich skeptisch, ob die Geschichte stimmen könnte, aber ich hab es nicht vergessen. So etwas ist also vermutlich schon seit dieser Zeit bekannt, und wird heutzutage auch ernsthaft in der Medizin bei Menschen gemacht. Also wird die erwähnte Story auch kein fake gewesen sein. Oder wenn, dann gut gemacht. In einigen SF-Romanen kommt das auch schon mindestens seit 1970 vor. (Stromsüchtige aus Ringweltingenieure von Larry Niven)

Aber das sind operative Eingriffe ins Hirn, die ich nicht meine. Ich meinte schon den gleichen Elektrodenaufbau wie in den oben beschriebenen Testreihen, nur eben als Empfänger.

@Helmut, Aussicht auf Erfolg hätte der Empfänger nur, wenn Menschen gleich denken würden. Tun sie aber nicht, da reicht schon ein Blick auf schlichte Kommunikationswissenschaft. Um beim "Blatt" zu bleiben: Da tauchen soviele verschiedene Bilder in verschiedenen menschlichen Gehirnen auf, wie es Blätter gibt und auch nicht alle sind grün. Und ein Teil denkt auch an "Papier". Wenn so ein simpler Sachverhalt schon so schwer zu verstehen ist, also man sich schon Einiges dazu denken muß (z.B. Kulturkreis, Köpersprache, Gesamtzusammenhang), damit die Information wenigstens halbwegs korrekt ankommt, kann man erahnen, wieviel Raum für Mißverständnisse ein Algorithmus da rausrechnen soll, wenn es um einen komplexen Sachverhalt geht, zuzüglich Meß- und Übertragungsfehler… Es gibt Dinge, die Computer nie alltags- und massentauglich können werden, weil Rechenleistung- und -zeit nie an Echtzeit und notwendige Genauigkeit herankommen werden. Siri und Alexa mit "Mach mal hell" das Licht anmachen lassen? Ja. Siri und Alexa mit den Worten "Hol was Leckeres" bei Amazon fresh einkaufen schicken? – Eher nein, wenn es wirklich was Leckeres sein soll :O)

Ich stimme Emelie zu und will ergänzen, dass man die Ableitung durch ein EEG nicht einfach "umkehren" kann, um Impulse an das Gehirn zu senden. Die Elektroden fangen ja Signale von verschiedenen Regionen ein und bilden daraus eine zweidimensionale Kurve. Sie können aber nicht im Gegenzug elektrische Impulse in ein dreidimensionales Gehirn schicken (gesetzt den Fall, man wüsste, was genau man wo reizen müsste, um eine komplexe Wahrnehmung zu erzeugen). Sie würden ja ihre Stromimpulse immer nur da erzeugen, wo sie auf der Kopfhaut sitzen. Das wäre so ähnlich, als wollte man mit einem Fotoapparat ein Hologramm erzeugen.

Ach Emelie, ich hatte gar nicht gemerkt, daß du dich eingebracht hattest. Weißt du, es wäre ja zu schön, wenn ich so ganz beiläufig eine Idee einbringe, die andere dann mühsam experimentell überprüfen, und wenn es dann klappen sollte, hätte ich einen Miterfinderanspruch.

TJa, leider sind solche Treffer seltener, als ich es gerne hätte. Aber ich muß es ieinfach mmer wieder probieren. Schnapsidee hin, Schnapsidee her. Da bin ich unverbesserlich.